キトー君

キトー君で真性包茎対策ができてしまいます。

包皮を引っ張ることで矯正できてしまうんですよ。

包皮輪狭窄の方も皮を伸ばすことでだんだんと広がっていきます。

テレビや雑誌でも紹介され多くの方が悩みを解決していますのでおすすめです。

キトー君の悪い口コミと失敗談

固定が出来なかった

私は真性包茎でそれがとても悩みでした。

少しケチってキトー君DXではなくキトー君を購入しました。

それが失敗でした…。

キトー君だとDXと違い固定ができないので自分でずっと持っていなければならず続けるのがしんどいです。

それにちゃんと固定できないから何度も外れるし…

キトー君DXにしておけばよかった

キトー君DXだとストッパーがあるのですがキトー君はありません。

なので毎日自分で30分間広げた状態で保持するのはしんどかったです。

輪ゴムを使って固定したりもしましたがゴムが強ければ痛いです。

DXにしておけばよかったと後悔しています。でも何とか皮は広がりました。

腕が疲れる

毎日使用していますがストッパーがないので固定は自分の手で握っている状態だから腕がとても疲れます。

輪ゴムを使って固定する方法を思いついたのですがゴムの強さによってものすごく包皮が広げられるのでとても痛いです。

不衛生だし何度も調整しないといけないしただただ時間と労力を削られただけでした。

ほんの少しの事ですがストッパーがあッた方がよかったと本当に後悔しています。

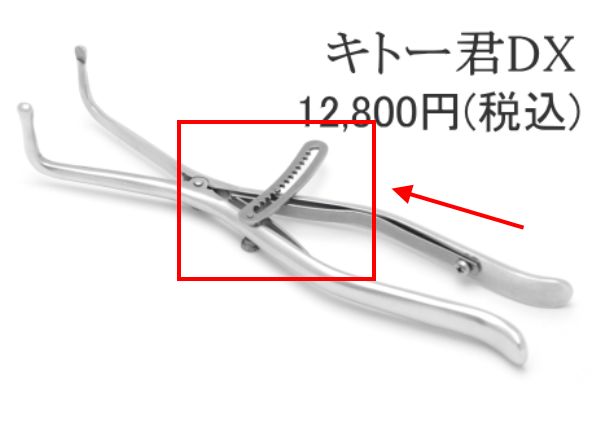

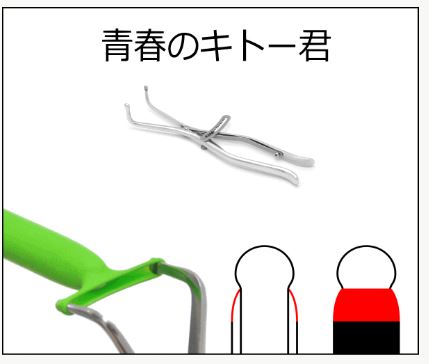

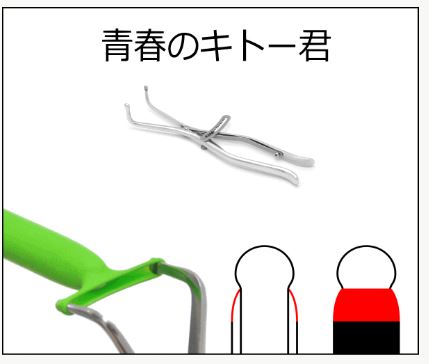

キトー君にはスプリングタイプのキトー君とストッパータイプのキトー君DXがあるのをご存知ですか?

| キトー君 | キトー君DX |

|---|---|

|

|

図の赤印で示してあるようにキトー君DXにはストッパーがついていてキトー君にはついていません。

このためストッパーがついていないということは30分間握って保持しないといけないという事なのです。

30分間一定の力で力を加え続けることができますか?

一日2回ですよ、それも2週間も。

ストッパーがあるほうが腕が疲れないのは誰にだってわかりますよね。

手を放して他の事も出来ますし。何より疲れませんしリラックスできます。

もし購入する方はキトー君DXを絶対におすすめします。

真性包茎は矯正できます。

包皮を伸ばし続けると伸びていきます。

このためには絶対に必要なことが継続することなのです。

ストッパーがなければ挫折するかもしれません。

折角矯正器具を手に入れても使わなければ効果が出ませんよね。

悩みを解決するために調べたのに

勇気を出して購入したのに

恥ずかしい気持ちを抑えて使用したのに

結果失敗したなんてことにはなってほしくないです。

キトー君にはストッパーがあったほうが絶対にいいのです。

では実際にキトー君DXを使用して効果があった口コミを見てみましょう。

包皮狭窄輪の私でもほんとに皮が伸びました

キトー君DXを使用し始めて3週間が経ちました。初めは使い方がいまいちで痛みを我慢したり間違った使い方をしていました。

結構伸ばしても痛くないのでかなり引っ張ることができます。耳たぶを引っ張ってもあまりいたくないのと同じですね。

痛みが出るギリギリのところで固定してやれば皮はどんどん伸びますね。

真性包茎なのですが効果ありました。

毎日継続してちゃんと続ければ2週間で本当に効果が出て驚いています。

使用して10日経ちます。だんだんと皮の最大直径が大きくなっているのが分かります。

あともう少しで余裕で向けるところまで来そうなので引き続き頑張ります。

羞恥心への配慮ができている

注文するのが恥ずかしかったのですが、中身が分からないよう梱包されており頼んでよかったです。

自分は一人暮らしなので誰にもばれずに受け取れますが局留めが出来たりと羞恥心への配慮が完璧だと思いました。

こういう配慮をしているのがとても親切だと思います。

剥けました

包皮狭窄輪で真性包茎が悩みでした。温泉に行くのも旅行に行くのもそのことがあるおかげで楽しさは半減していました。本当に手術をしようか迷っていたくらいです。

そこでキトー君DXのことを知り毎日欠かさずに包皮輪を引っ張ると本当に剥けるようになりました。

包皮が被っているとものすごく臭いがします(カスが溜まっている)し不衛生だということがよくわかりました。

皮がむけてから亀頭がパンツにすれるたびにビクンビクンしましたが、今では慣れてきました。

おかげで臭いもなくなりとてもいい状態(これが普通)です。

自分に自信が持てました

今まで包茎だったのが本当にコンプレックスでした。

これのおかげで銭湯や温泉でも堂々とできて余計なことを考えなくて済みます。

臭いがしたりカスが溜まることも無くなり本当に清潔になりました。

女の子に嫌がられることも無くなり自分に自信が持てるようになりました。

多くの方が皮が伸びたと口コミされ評判が良いいです。

公式サイトですと楽天よりも約1,000円安いので値段の心配をしている方にも公式サイトでの購入をおすすめします。

キトー君の販売店舗情報

キトー君は以前は楽天やアマゾンでも購入することが出来ました。

しかし今は上記の販売店では取り扱っていません。

きとーくんを購入できるのは公式サイトでのみ購入できます。

ドンキホーテでも販売されていません

楽天で販売が再開されました。

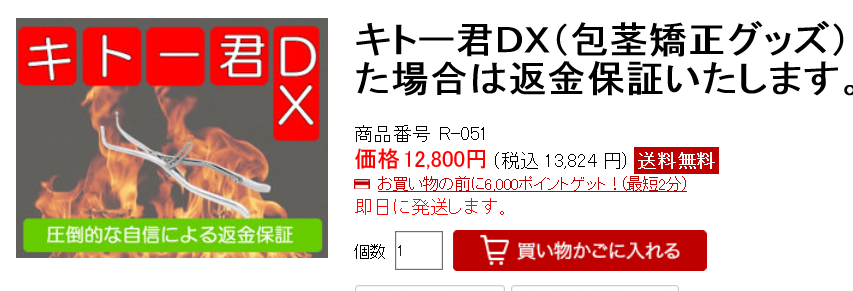

キトー君の販売価格は 9800円

キトー君DXの販売価格は 12800円(税込13,824円)です。

公式サイトですと税込で12,800円で購入でき1,000円もお得です。

ちゃんとした結果を得たいならキトー君DXをおすすめします。

公式サイトは安心のサービスがあります。

・返金制度

・手術代保証制度

配達方法も宅配と郵便局留めが選べます。

郵便局留を利用すると、ご家族に知られる心配が全くありません。

商品はお客様のお好きな郵便局に送られます。

品物が届いてもご自宅に連絡がいくことはありません。

「お名前」「郵便局名」さえ分かれば、指定の郵便局へお届けすることができます。

注文確認メールにて、到着予定日をお知らせ致しますので、商品が届いた頃に、郵便局においで頂きます。

代金は、商品と引き換えにお支払い頂きます。

ご住所を記入して頂く必要が無いので、個人情報が完全に守られます

お支払いの方法は2種類あります。

・代金引換

・現行振り込(後払い)

配達の希望日時も選べるので便利です。

キトー君Q&A

「郵便局止め」をご利用頂ければ、ご家族に知られることはありません。

お客様にはご希望の郵便局をご指定頂きます。

商品はその郵便局に止め置かれるので、お客様のご都合の良い時に受け取りにおいで頂きます。

商品がご自宅に届くことも、郵便局からご自宅に連絡が行くこともありません。

大きい郵便局の方が受け取りやすい雰囲気です。

いいえ、「キトー君」などといった表記は一切ありません。

また、発送者欄は個人名にてお送り致します。

ご満足いただけなかった場合、本当に返金、手術代金の保証を致します。

後になって言い逃れするような卑怯な真似は致しません。

商品に自身があるからこそ可能なサービスです。

商品購入の如何に関わらず、何でも気軽にお問い合わせ下さい。

お客様の問題が完全に解決されるまで、全力でサポート致します。

キトー君の効果

|

|

|

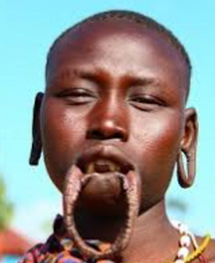

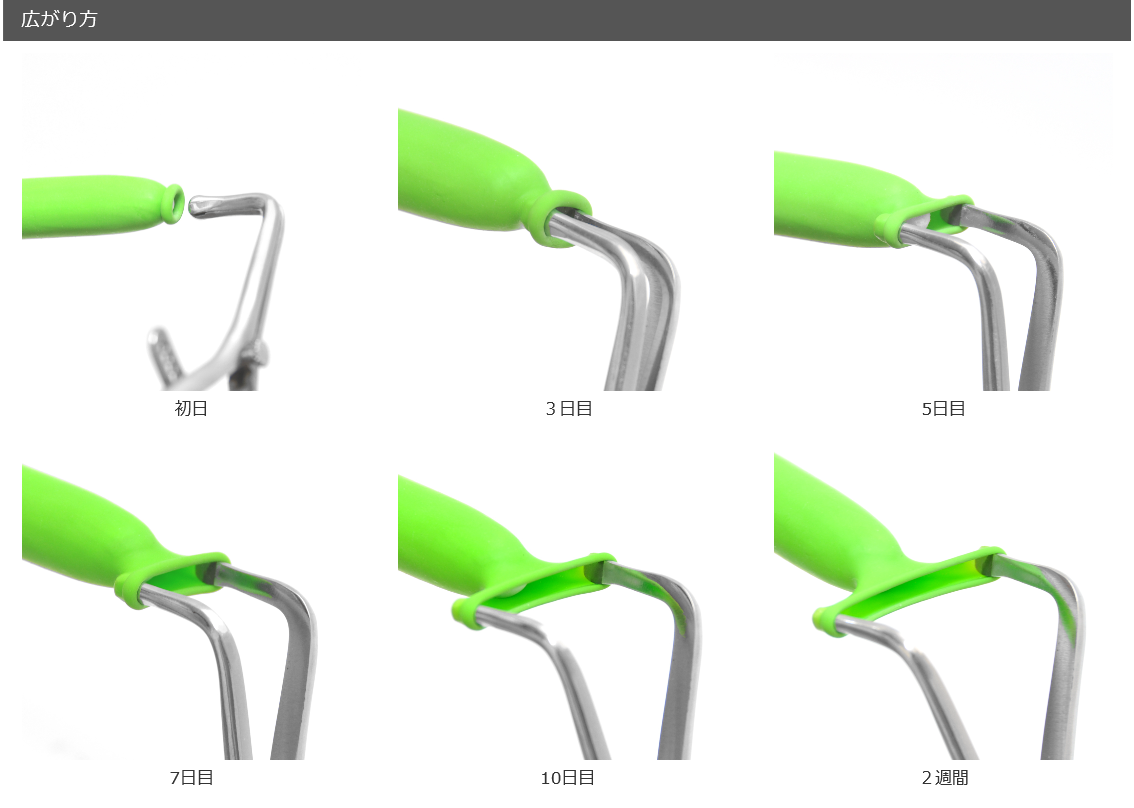

上の図の様に皮や首などは時間をかけて引っ張れば伸びていきます。

テレビで見たことがあるでしょう。

太っている方が急に痩せると皮がだぶつきますよね

ピアスの穴もどんどん広げることもできるように皮というのは伸びるようになっています。

正確には適応しているという感じですね。

彼らも初めは私たちと変わらない唇や首の長さでした。

唇や耳の場合穴をあけてから少しづつ直径の大きなものをはめ込んでいくことにより皮はだんだんと伸びていくのです。そして一度伸びてしまうと元には戻らないのです。

包皮輪も皮を伸ばした状態で30分保持を毎日繰り返すだけで少しづつ皮は伸びていきます。

大切なのは毎日続けることです。

個人差はあるようですが2週間から4週間で長年の悩みが解決されます。

そしてこれからの悩みも解決してくれます。

毎日皮を伸ばせば必ず伸びます。

2週間毎日継続すれば必ず効果を感じられますよ。

キトー君は危険か安全か

キトー君は使い方を間違えれば危険です。

キトー君の使い方は包皮輪に入れて広げます。

そこには亀頭があって尿道口があります。

もしキトー君が不潔なら?

そう、ばい菌が入ってしましまうんですよ、尿道口から。

ですから使用する前はアルコール消毒してください。

お風呂で使用する場合は薬用石鹸ミューズがいいですね。

普通の固形石鹸だと油汚れは落とせても殺菌まではしてくれません。

次にはやく包茎を治したいという気持ちが強く、包皮を強く引っ張りすぎることです。

無理にしすぎると皮膚が避けたり傷がついたりします。

そこからばい菌が入って腫れあがることも考えられます。

そうなるともう包茎を矯正したりすることができなくなりますよね。

急がば回れですね。

毎日無理なく使用することをおすすめします。

まとめ

・使用前はアルコールか薬用石鹸ミューズで消毒する

・傷ができるくらい無理して広げない

これらを守ればキトー君は安全に使用することができます。